- Por primera vez, un estudio científico ha intentado medir el impacto del uso repetido de ChatGPT en el cerebro.

Los resultados —publicados en un preprint por el MIT Media— marcarían una clara tendencia: trabajar con modelos de lenguaje de IA provocaría una pérdida de control cognitivo y modificaría el comportamiento.

Más preocupante aún: los usuarios integrarían pasivamente los sesgos algorítmicos de los diseñadores de LLM.

Resumimos las principales conclusiones de un estudio que tiene el mérito de abrir el debate sobre una nueva frontera geopolítica —nuestro cerebro—.

Puntos claves

- El estudio de la actividad cerebral de una pequeña muestra de 54 personas que realizaron tres sesiones espaciadas a lo largo de cuatro meses mostraría que, a nivel neuronal, lingüístico y conductual, los usuarios de ChatGPT obtienen sistemáticamente peores resultados que las personas que no utilizan el chatbot para las mismas tareas.

- El 83,3 % de los usuarios de ChatGPT sometidos a la prueba del estudio no fueron capaces de citar pasajes de ensayos que habían redactado unos minutos antes.

- En este experimento, el 55 % de la «carga cognitiva» necesaria para redactar un ensayo sin ayuda alguna disminuiría con el uso de un LLM, lo que provocaría una especie de atrofia cerebral.

- Con el tiempo, escribir con ChatGPT acumularía una «deuda cognitiva» que dificultaría el retorno a una actividad cerebral normal para las tareas realizadas sin LLM.

- Un preprint es un artículo que aún no ha sido sometido a una evaluación por pares. Por lo tanto, es posible que contenga errores metodológicos y que sus conclusiones puedan modificarse sustancialmente.

En un preprint de 206 páginas publicado por el MIT Media Lab, Nataliya Kosmyna y sus coautores (disponible en su totalidad en este enlace) presentan por primera vez de forma tan precisa los efectos del uso de modelos de lenguaje (LLM) como ChatGPT en el cerebro humano.

1 — Un estudio cualitativo: metodología de un dispositivo experimental inédito

En su experimento, llevado a cabo en el MIT durante varios meses, los investigadores examinaron el esfuerzo cognitivo inducido por tres modos de redacción de un ensayo para el examen de acceso a la universidad en Estados Unidos (SAT) y estudiaron la actividad cognitiva de tres grupos distintos observando los mismos indicadores en cada uno de ellos.

- un primer grupo redactaba sin ninguna ayuda (brain-only);

- un segundo grupo con un motor de búsqueda clásico (un Search Engine como Google)

- un tercer grupo con el modelo de lenguaje de ChatGPT (LLM).

54 voluntarios reclutados por el MIT Media Lab realizaron tres sesiones espaciadas a lo largo de cuatro meses.

Cada sesión consistía en redactar, en veinte minutos, un ensayo sobre uno de los nueve temas proporcionados, a razón de tres temas diferentes por sesión.

Estas tres sesiones permitieron a los investigadores identificar las diferencias en la actividad cerebral en términos de actividad cognitiva, tipo de esfuerzo movilizado —comparando qué zonas del cerebro se movilizan más— y las repercusiones conductuales inducidas por el uso de un motor de búsqueda o un LLM , como la capacidad de citar su trabajo, considerar su ensayo como propio y pensar de forma crítica.

Pero el experimento también trató de comprender, en las mismas condiciones de redacción, el efecto que podía tener el uso de un LLM —en este caso, ChatGPT— a lo largo del tiempo.

Con el fin de obtener métricas comparativas, 18 de los voluntarios del MIT regresaron para una cuarta sesión cruzada, en la que el objetivo era analizar los cambios en la actividad cerebral: de los que trabajaban con LLM a los que trabajaban sin ellos, y viceversa. En el estudio, estos grupos se denominan «LLM>Brain-only» y «Brain-only>LLM» (véase más adelante, punto 4).

Las condiciones experimentales para los tres tipos de redacción fueron las siguientes:

- en el caso de la ayuda LLM, la redacción se realizó con el uso exclusivo de GPT-4o en una ventana dedicada y no se permitió el acceso a ningún otro sitio web;

- en el caso del motor de búsqueda clásico, el acceso a internet era libre, excepto a los LLM;

- en el caso de la redacción sin ayuda (brain-only), no se permitía el uso de ninguna herramienta digital, es decir, ninguna pantalla.

Mientras redactaban, los voluntarios fueron sometidos a un registro neurofisiológico mediante una serie de electrodos y sensores colocados directamente sobre el cuero cabelludo.

Para complicar la operación y reproducir las condiciones del entorno escolar, una última etapa consistió en la corrección de los exámenes por parte de personas y de una IA diseñada a medida.

Por último, al final del experimento, los voluntarios fueron sometidos a un cuestionario.

Realizada con un número reducido de participantes, esta prueba, esencialmente cualitativa, permite establecer tendencias que podrían servir de pista para la investigación, a la espera de estudios cuantitativos realizados con muestras más amplias.

2 — Los efectos cognitivos del uso de ChatGPT: cómo los LLM atrofian nuestra actividad cerebral

Los resultados del estudio son inequívocos: la «conectividad cerebral» disminuye sistemáticamente en función del apoyo externo.

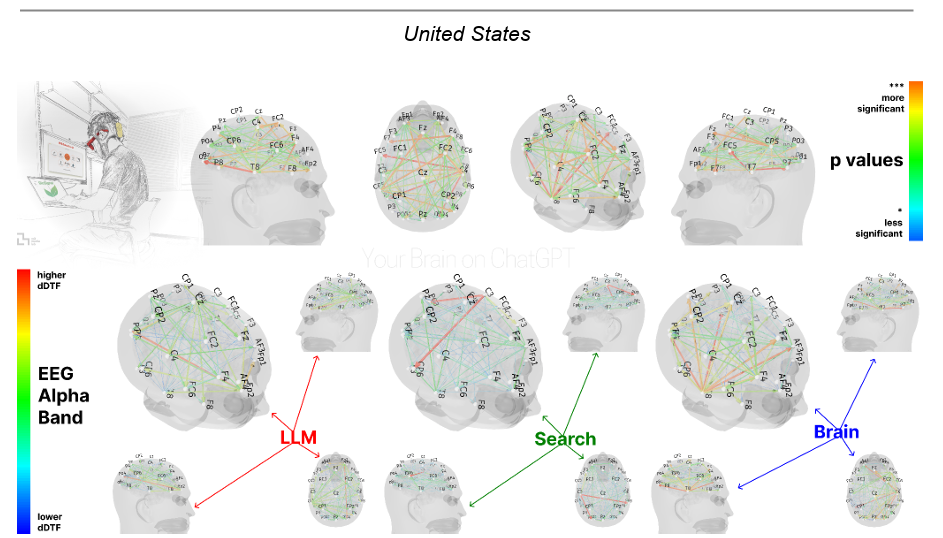

El grupo que trabajó solo con su cerebro presentó las redes neuronales más sólidas y extensas; el grupo que utilizó un motor de búsqueda mostró un compromiso intermedio; y el grupo que trabajó con el apoyo de un LLM mostró la menor conexión global.

En otras palabras: cuanto mayor es el apoyo externo, menor es la amplitud de las zonas activas del cerebro.

Esta amplitud se estudia a partir de un indicador, la Dynamic Direct Transfer Function (dDTF).

Obtenida a partir de los datos registrados por los electrodos, esta herramienta matemática sirve para observar, instante a instante, qué zona del cerebro «controla» directamente a otra a una frecuencia determinada. Permite a los neurocientíficos seguir en tiempo real el flujo directo de información entre regiones cerebrales, frecuencia por frecuencia, y extraer marcadores relevantes.

Las cifras del estudio son sorprendentes: el grupo que trabajó sin ayuda tuvo la actividad más alta, mientras que el que trabajó con un motor de búsqueda tuvo una actividad entre un 34 % y un 48 % inferior.

En cuanto al grupo que trabajó con ChatGPT, su amplitud cognitiva total se redujo en casi un 55 %.

La observación detallada de esta actividad en las diferentes zonas del cerebro revela varias particularidades.

- El grupo que redactó su texto con ayuda de un motor de búsqueda presenta una mayor actividad en el córtex occipital y visual, lo que revela que la actividad cerebral se centra en la búsqueda de información visual y su recopilación en la fase de investigación.

- Este resultado parece corroborar el hecho de que los participantes clasificaron y seleccionaron una serie de informaciones con el fin de redactar sus ensayos. Se trata de una «integración cognitivamente exigente de recursos visuales, atencionales y ejecutivos» movilizada por las pantallas.

- Aunque los usuarios de LLM también utilizan una pantalla, su grupo no presenta «niveles comparables de activación cortical visual». En otras palabras: el objetivo de su interacción con la pantalla parece ser distinto: el uso de ChatGPT reduce su necesidad de búsqueda visual prolongada y de filtrado semántico. La «carga cognitiva» se desplaza hacia la integración procedimental y la coordinación motora.

- Por último, el grupo que solo utilizó su cerebro muestra fuertes activaciones fuera de la corteza visual, en particular «en las regiones del cerebro implicadas en la integración semántica, la ideación creativa y el autocontrol ejecutivo».

Estos resultados sugieren que el uso de LLM, si bien aumenta el rendimiento de las tareas, tiene sobre todo un efecto en la arquitectura cognitiva.

Como revela el estudio: «El grupo «solo cerebro» utilizó amplias redes neuronales distribuidas para generar contenido internamente; el grupo «motor de búsqueda» se basó en estrategias híbridas de gestión de la información visual y control regulador; y el grupo «LLM» optimizó la integración procedimental de las sugerencias generadas por la IA».

3 — Consecuencias conductuales: la pérdida de capacidad de actuar inducida por el uso de LLM

¿Por qué los usuarios de ChatGPT no recuerdan lo que han escrito?

Los datos denominados «conductuales», en particular los relativos a la capacidad de citar, la exactitud de las citas y la apropiación de los ensayos, amplían y corroboran las conclusiones del estudio en materia de conectividad neuronal.

Estos resultados sugieren que la dinámica funcional de la red activada durante la redacción de un ensayo moldea procesos como la memoria, la eficacia del autocontrol y el grado de apropiación percibido del trabajo escrito.

La divergencia conductual más constante y significativa entre los grupos se observó en la capacidad de citar de memoria el propio ensayo.

- Los usuarios de LLM obtienen resultados significativamente inferiores en este ámbito: el 83 % de los participantes afirman tener dificultades para citar su ensayo después de la primera sesión, y ninguno proporciona una sola cita correcta de su propio trabajo.

- Esta deficiencia persiste, aunque de forma atenuada, en las sesiones subsiguientes: 6 de los 18 participantes siguen sin poder citarse correctamente en la sesión 3.

Esta dificultad corresponde directamente con la reducción de la conectividad cerebral en el grupo que utiliza un LLM: estas oscilaciones son, en efecto, generalmente más fuertes cuando los individuos generan y estructuran internamente contenidos en lugar de integrar pasivamente información generada externamente.

El estudio destaca en particular que la reducción de la actividad cognitiva en los usuarios de LLM «probablemente refleja una elusión de los procesos de codificación profunda de la memoria, ya que los participantes leen, seleccionan y transcriben las sugerencias generadas por la herramienta sin integrarlas en las redes de memoria episódica».

Los voluntarios que utilizaron un motor de búsqueda como Google o que no se basaron en ninguna herramienta digital no presentaron tales deficiencias.

- En la sesión 2, ambos grupos alcanzaron una capacidad de citación casi perfecta, y en la sesión 3, el 100 % de los participantes de ambos grupos declararon ser capaces de citar sus ensayos, observándose solo pequeñas diferencias en la precisión de las citas.

- Por el contrario, la ausencia total de citas correctas en el grupo LLM en la sesión 1 y las deficiencias persistentes en las sesiones siguientes sugieren que no solo la codificación de la memoria era superficial, sino que, sobre todo, es posible que el contenido semántico en sí mismo no se hubiera interiorizado por completo.

¿Quién es el autor de los textos escritos con IA? Estudio de una disociación

Otra gran divergencia de comportamiento que se desprende del estudio es la percepción que tienen los participantes de la autoría de su ensayo.

Mientras que el grupo que trabajó sin ayuda reivindica casi por unanimidad la plena propiedad de sus textos (16/18 en la primera sesión y 17/18 en la tercera), el grupo que redactó con ChatGPT muestra un sentimiento ambivalente al respecto.

- Así, algunos participantes afirman ser los autores de sus textos, otros lo niegan explícitamente y muchos se atribuyen solo una parte del mérito (entre el 50 % y el 90 %).

- Esta co-creación entre humanos e IA ha sido teorizada en nuestras páginas por el dispositivo Jianwei Xun, que propone, a través del concepto de hipnocracia, un nuevo dispositivo de escritura que asume plenamente y construye a partir de la aportación de los modelos de lenguaje en los procesos de autoría.

En total, el estudio concluye que «estas respuestas sugieren una disminución del sentimiento de agencia cognitiva».

Según los autores, esto pone de manifiesto un problema: las herramientas de IA, aunque son valiosas para apoyar el rendimiento, pueden obstaculizar involuntariamente el procesamiento cognitivo profundo, la retención y el compromiso auténtico con el material escrito.

Esta observación experimental parece demostrar que, si los usuarios dependen en exceso de las herramientas de IA, pueden creer que están adquiriendo un dominio superficial sin llegar a interiorizar y apropiarse de los conocimientos.

4 — La IA destructiva: observar los daños causados por el LLM en el cerebro.

Uno de los aspectos interesantes de este estudio es que se propuso a algunos voluntarios una cuarta sesión de escritura.

Durante esta sesión, los grupos intercambiaron sus prácticas para buscar diferencias en la actividad cognitiva al pasar del uso repetido del LLM a no utilizarlo en absoluto, y viceversa.

El cambio es sorprendente: los voluntarios que pasaron de ChatGPT al uso exclusivo de sus cerebros tienen dificultades para recrear una red de conexiones y una actividad cerebral tan rica; los que pudieron utilizar la IA tras tres intentos libres mostraron un pico de actividad sin precedentes, lo que indica que utilizan la herramienta como un multiplicador más que como un sustituto, y también escriben indicaciones más precisas y variadas.

Los que habían escrito anteriormente sin herramientas y a los que se les permitió utilizar la IA (el grupo denominado «Brain-only > LLM») muestran un aumento significativo de la conectividad cerebral global, lo que sugiere que la movilización apoyada por la IA provoca altos niveles de integración cognitiva, reactivación de la memoria y control descendente.

Por el contrario, en el grupo que había escrito con IA en las primeras sesiones y tuvo que prescindir de ella en la cuarta, el uso repetido del LLM reflejó una clara reducción de la conectividad a lo largo del tiempo.

Según los autores: «Estos resultados ponen de relieve la interacción dinámica entre el apoyo cognitivo y la participación neuronal en contextos de aprendizaje asistido por IA».

5 — Inception: el rastro del algoritmo frente al rastro de la memoria

Otra conclusión más preocupante de la cuarta sesión es que los voluntarios del grupo «LLM > Brain-only» se centraron repetidamente en un conjunto más reducido de ideas.

Según los autores, esta repetición podría sugerir que muchos participantes quizá no se involucraron profundamente en los temas o no examinaron críticamente el material proporcionado por el LLM.

Este patrón reflejaría la acumulación de una «deuda cognitiva»: el uso repetido de sistemas externos como los LLM sustituiría los procesos cognitivos exigentes necesarios para el pensamiento independiente por procesos puramente integradores.

Por lo tanto, la deuda cognitiva pospondría el esfuerzo mental a corto plazo, pero conllevaría costos a largo plazo, como una disminución del espíritu crítico, una mayor vulnerabilidad a la manipulación y una disminución de la creatividad.

El estudio concluye a este respecto que «cuando los participantes reproducen sugerencias sin evaluar su exactitud o pertinencia, no solo renuncian a la propiedad de las ideas, sino que también corren el riesgo de interiorizar perspectivas superficiales o sesgadas».

El análisis de estos diferentes resultados muestra que una dependencia temprana de la IA podría conducir a una codificación más superficial de la memoria.

Las importantes deficiencias del grupo que utilizaba LLM, especialmente en términos de memoria, podrían ser un signo de una integración interna deficiente durante las primeras pruebas, probablemente atribuible a un procesamiento cognitivo externalizado hacia el LLM.

Por el contrario, el simple hecho de no utilizar los LLM durante las fases iniciales podría favorecer la aparición de la memoria.

En el caso de los redactores que no utilizaron ninguna ayuda digital, los esfuerzos iniciales sin ayuda favorecieron la formación de huellas memorísticas duraderas, lo que permitió una reactivación más eficaz, incluso cuando se introdujeron posteriormente las herramientas LLM.

——————-